ABD’deki New York Üniversitesi’nden araştırmacılar, Sam adlı bir bebeğin gördüklerini kullandı ve yapay zekayı; sözcükleri ve görüntüleri birbirine bağlayacak şekilde eğitti.

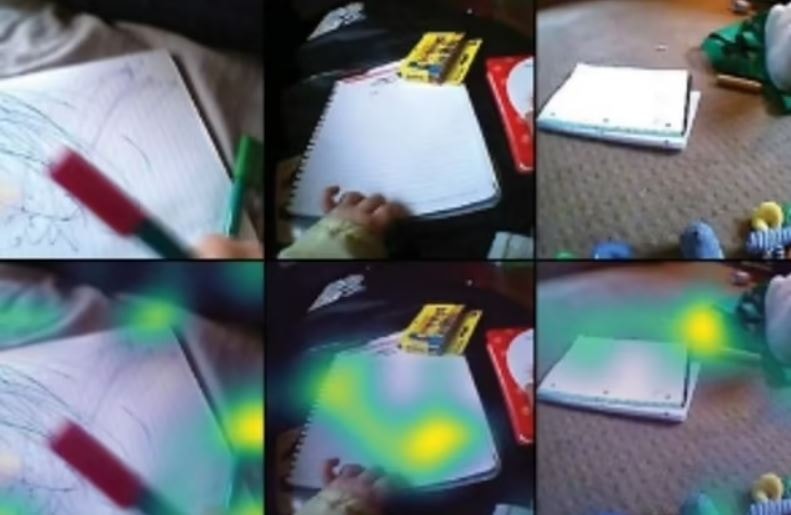

Çalışma için henüz altı aylıkken Sam'e bir kafa kamerası bağlandı. Kayıt yapan cihaz, bebek iki yaşına gelene kadar kullanıldı.

250.000 kelimeden ve bunlara karşılık gelen görsellerden oluşan görüntüler, farklı nesnelerin nasıl tanınacağını öğrenen bir yapay zeka modelini besledi.

Yapay zeka da tıpkı çocuğun yaptığı gibi çevreyi gözlemleyerek, yakındaki insanları dinleyerek ve görülen ile duyulan arasındaki noktaları birleştirerek bilgisini geliştirdi.

Araştırmacılar, insanların sözcüklerle görsel olarak nasıl bağlantı kurduklarını keşfetti. Örneğin "top" sözcüğü diğer özellikler, nesneler veya olaylar yerine yuvarlak, sıçrayan bir nesneyle ilişkilendirildi.

Kamera, Sam'in yemek zamanları, kitap okuma ve oyun oynama gibi günlük aktivitelerini kaydetti, bu da yaklaşık 60 saatlik veriye tekabül ediyordu.

Araştırmacılar, yapay zeka modelinin Sam'in kamerası aracılığıyla elde edilen görüntüleri yorumlaması için görüntüleri ve yazılı dili tercüme etmek amaçlı bir görüntü ve metin kodlayıcı kullandı.

Araştırmacılar, modelin birçok kelime ve görseli doğru şekilde eşleştirebildiğini buldular.

Bulgular, yapay zeka modelinin öğrendiklerini yüzde 61,6 doğruluk oranıyla genelleyebildiğini ve "elma" ve "köpek" gibi görünmeyen örnekleri yüzde 35 oranında doğru bir şekilde tanımlayabildiğini gösterdi.

NYU Veri Bilimi Merkezi'nde araştırma bilimcisi olan Wai Keen Vong, "İlk kez, tek bir çocuktan gelen eğitilmiş bir sinir ağının, sözcükleri görsel karşılıklarıyla ilişkilendirmeyi öğretebileceğini gösterdik."

"Sonuçlarımız, bir çocuğun doğal deneyimiyle eşleştirilen ilerlemelerin, erken dil ve kavram edinimi anlayışımızı nasıl yeniden şekillendirme potansiyeline sahip olduğunu gösteriyor." dedi.